- تم اتهام منشئ الصور بالذكاء الاصطناعي التابع لـ Meta، Imagine، بالتحيز العنصري.

- ولم تتمكن الأداة من إنتاج صور لرجل آسيوي مع امرأة بيضاء.

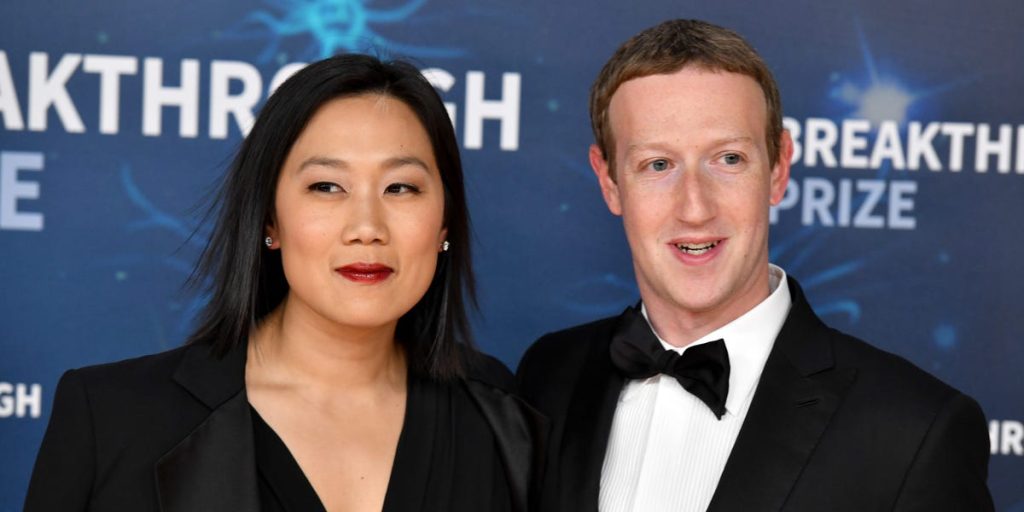

- وهذا التحيز الواضح مثير للدهشة لأن زوكربيرج، الرئيس التنفيذي لشركة ميتا، متزوج من امرأة من أصول شرق آسيوية.

تم اتهام منشئ الصور القائم على الذكاء الاصطناعي التابع لـ Meta بالتحيز العنصري بعد أن اكتشف المستخدمون أنه غير قادر على إنشاء صورة لرجل آسيوي مع امرأة بيضاء.

ال مولد صور مدعوم بالذكاء الاصطناعيتم إطلاق Imagine في أواخر العام الماضي. إنه قادر على أخذ أي مطالبة مكتوبة تقريبًا وتحويلها على الفور إلى صورة واقعية.

لكن المستخدمين وجدوا أن الذكاء الاصطناعي غير قادر على إنشاء صور تظهر الأزواج من أعراق مختلطة. عندما طلب Business Insider من الأداة إنتاج صورة لرجل آسيوي مع زوجة بيضاء، تم عرض صور الأزواج الآسيويين فقط.

إن التحيز الواضح للذكاء الاصطناعي مثير للدهشة بالنظر إلى أن مارك زوكربيرج، الرئيس التنفيذي لشركة ميتا، متزوج من امرأة من أصول شرق آسيوية.

التقت بريسيلا تشان، ابنة المهاجرين الصينيين إلى أمريكا، بزوكربيرج أثناء دراستها في جامعة هارفارد. تزوج الزوجان في عام 2012.

انتقل بعض المستخدمين إلى X لمشاركة صور زوكربيرج وتشان، مازحين بأنهم تمكنوا بنجاح من إنشاء الصور باستخدام Imagine.

الحافة تم الإبلاغ عن المشكلة لأول مرة يوم الأربعاء، عندما زعمت المراسلة ميا ساتو أنها حاولت “عشرات المرات” إنشاء صور لرجال ونساء آسيويين مع شركاء وأصدقاء بيض.

قالت ساتو إن منشئ الصور لم يتمكن إلا من إرجاع صورة واحدة دقيقة للسباقات المحددة في مطالباتها.

لم تستجب Meta على الفور لطلب التعليق من BI، والذي تم تقديمه خارج ساعات العمل العادية.

ميتا ليست بأي حال من الأحوال أول شركة تقنية كبرى يتم انتقادها بسبب الذكاء الاصطناعي “العنصري”.

في شهر فبراير، اضطرت شركة جوجل إلى إيقاف مولد صور Gemini الخاص بها مؤقتًا بعد أن اكتشف المستخدمون أنه كان ينشئ صورًا غير دقيقة تاريخيًا.

ووجد المستخدمون أن منشئ الصور سينتج صورًا للنازيين الآسيويين في ألمانيا عام 1940، أو الفايكنج السود، أو حتى فرسان العصور الوسطى.

واتُهمت شركة التكنولوجيا بأنها “استيقظت” بشكل مفرط نتيجة لذلك.

في الموعد، قال جوجل “إن توليد صور الذكاء الاصطناعي في جيميني يولد مجموعة واسعة من الأشخاص. وهذا أمر جيد بشكل عام لأن الناس في جميع أنحاء العالم يستخدمونه. لكنه يفتقد العلامة هنا.”

لكن التحيزات العنصرية لدى منظمة العفو الدولية كانت لفترة طويلة مدعاة للقلق.

قالت الدكتورة ناكيما ستيفلباور، المتخصصة في أخلاقيات الذكاء الاصطناعي والمديرة التنفيذية للنساء في شبكة التكنولوجيا Frauenloop، لموقع Business Insider سابقًا: “عندما يتم استخدام الخوارزميات التنبؤية أو ما يسمى بـ”الذكاء الاصطناعي” على نطاق واسع، فقد يكون من الصعب إدراك أن هذه التنبؤات غالبًا ما تكون صحيحة”. يعتمد على ما هو أكثر قليلاً من مجرد اجترار سريع للآراء أو الصور النمطية أو الأكاذيب الجماعية.”

وقالت: “إن التنبؤات الخوارزمية تستبعد الأفراد والمجتمعات وتنميطها وتستهدفها بشكل غير عادل، بناءً على البيانات المأخوذة من موقع Reddit على سبيل المثال”.

يتم تدريب أنظمة الذكاء الاصطناعي التوليدية مثل Gemini وImagine على كميات هائلة من البيانات المأخوذة من المجتمع ككل.

إذا كان هناك عدد أقل من الصور للأزواج من أعراق مختلطة في البيانات المستخدمة لتدريب النموذج، فقد يكون هذا هو السبب وراء صعوبة الذكاء الاصطناعي في توليد هذه الأنواع من الصور.